http://www.01net.it/iperconvergenza-chiama-software-defined-storage/

La virtualizzazione delle applicazioni è una pratica ormai ampiamente adottata. Dopo gli entusiasmi iniziali si è, però, compreso che una delle principali difficoltà è legata allo storage condiviso, che è elemento essenziale per la buona riuscita della virtualizzazione.

A sostenerlo è George Teixeira, Ceo di Datacore, ricordando che le applicazioni possono essere spostate tra i vari server solamente se quest’ultimi sono in grado di accedere a programmi e relativi dati memorizzati sulle unità di storage.

In un ambiente tipico, lo storage condiviso viene collocato in reti dedicate, le Storage area network, che, nate prima della virtualizzazione, si trovano oggi ad affrontare sfide complesse, che non sempre riescono a superare nel migliore dei modi. Gli ambienti virtualizzati, ricorda Teixeira, hanno, infatti, bisogno di prestazioni in input e output uniformi e affidabili in ogni momento, anche quando le applicazioni diventano più esigenti. I carichi di lavoro virtualizzati possono, infatti, variare enormemente e velocemente.

Virtualizzazione dello storage e soluzioni hyperconverged

https://www.datacore.com/products/hyperconverged-storage/

“Basti pensare a un database: quando viene avviata un’attività di elaborazione dei dati particolarmente rilevante, la San si ritrova sotto pressione, con ripercussioni sulle prestazioni generali che hanno un impatto anche su tutte le altre applicazioni. Ovviamente più queste sono sensibili alle prestazioni, più i problemi crescono”.

In prima fila, come già accennato dal Ceo di Datacore, ci sono soprattutto i database e le applicazioni o i sistemi di Erp basati sui database, “come Oracle, Microsoft Sql Server, Sap, Microsoft Dynamics senza trascurate le Vdi di Vmware o di Citrix, e i sistemi di comunicazione, dal VoIp a Microsoft Exchange”.

Non solo prestazioni

Le prestazioni non sono, però, l’unico parametro da tenere in considerazione nelle San collocate in ambienti virtualizzati. Affidabilità e complessità possono rivelarsi un vero e proprio grattacapo, soprattutto nelle strutture più piccole, così come la scalabilità orizzontale e la manutenzione. Se il numero di applicazioni tende a crescere, cosa pressoché certa con le tendenze attuali, la San deve essere in grado di adeguarsi velocemente e in modo trasparente. E anche in caso di manutenzione è impensabile immaginare che lo storage possa essere messo temporaneamente offline. Eppure, come ricorda Teixeira, questo accade.

Negli uffici remoti che dispongono di applicazioni onsite le difficoltà aumentano. Si parla di negozi, filiali, impianti produttivi, call center dove la gestione e la disponibilità dell’infrastruttura possono diventare complicate. Come minimo, per garantire elevata disponibilità a livello di macchine fisiche è necessario dislocare una coppia di server, che devono essere ovviamente connessi a una Storage area network. Per ragioni legate ai costi quest’ultima è spesso costituita da una batteria di storage economica, il che si traduce in ciò che viene definito un “single point of failure”, ovvero l’anello debole nella catena: se per qualunque ragione la San va offline, la presenza del doppio server non basta a garantire la continuità del servizio. E spesso la mancanza in loco di staff dedicato alla gestione It complica ulteriormente le cose.

I vantaggi dell’iperconvergenza

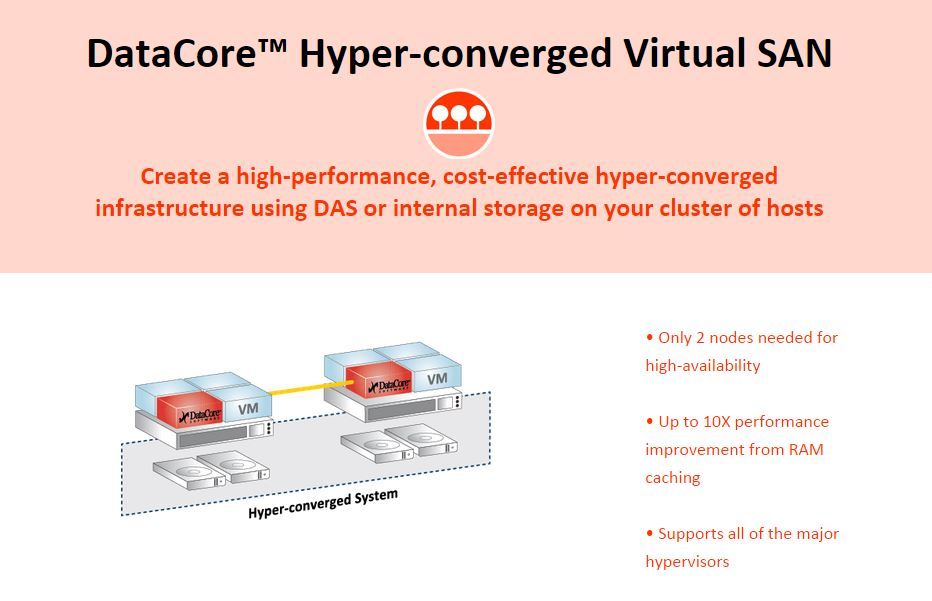

Tutti questi aspetti stanno spingendo le aziende alla ricerca di nuove soluzioni. Una delle più gettonate è conosciuta come iperconvergenza, in cui l’infrastruttura It, intesa come potenza di calcolo, memoria, collegamenti di rete e sistemi di storage, viene completamente integrata, semplificandone sia l’installazione sia la successiva gestione. Per ottenere il miglior risultato prestazionale possibile, si procede di norma con la creazione di cluster specializzati, che riuniscono applicazioni dello stesso tipo. Per avvicinare fisicamente i dati alle applicazioni, lo storage viene installato all’interno o accanto ai server in modalità Das, ossia Direct-attached storage.

In questo modo si possono ottenere tempi di risposta più veloci migliorando le prestazioni di input e output.

L’importante è scalare

In generale, quando si considera una soluzione iperconvergente bisogna valutare anche la sua capacità di scalare. È inutilmente costoso avere un sistema che non permette di aumentare la capienza dello storage se non incrementando contestualmente anche capacità di calcolo e memoria.

Da qui il suggerimento di optare per architetture che consentono di utilizzare una San centralizzata come complemento allo storage collegato direttamente ai server. Questo consente una grande flessibilità, garantendo in ogni caso che l’allocazione dei dati sul “livello” di storage più adeguato alle esigenze prestazionali: i dati attivi rimangono sempre sullo storage collegato ai server, mentre quelli utilizzati con frequenza inferiore vengono memorizzati sulla San.

Infine, a conclusione di questa panoramica sui sistemi iperconvergenti, il Ceo di Datacore afferma che l’unico vero rischio che queste soluzioni comportano è di diventare sistemi isolati che richiedono gestione e manutenzione separate. Per questo è necessario pensare alla loro integrazione nell’infrastruttura globale.